Ada satu pertanyaan dari teman saya yang membuat heran. Dia memiliki sebuah blog dengan forum yang cukup ramai kalau saya lihat tapi karena banyak spammer dan bot jahat yang menyerangnya ingin agar websitenya ini tidak bisa ditemukan di Google. Ya memang tidak salah sih, saya cek sumber asal pengunjungnya mayoritas Facebook dan Twitter dengan sedikit Pinterest.

Google dan mesin pencari lainnya (Bing, Yandex, Yahoo, Baidu, DuckDuckGo, dan sebagainya) akan mengunjungi situs anda kemudian mengindeks apa saja isinya. Mulai dari teks, gambar, video, audio, dan jenis – jenis konten semacamnya. Dan inipun tanpa perlu kita undang atau mendaftarkan alamat situs kemanapun, cuma lebih lama saja.

Solusinya? Kalau di WordPress ada opsi untuk menginstrusikan bot peramban ini (Discourage search engines from indexing this site / Halangi mesin pencari untuk mengindeks situs ini). Tapi kalau anda menggunakan CMS lain atau tidak ada cara yang sama maka kita perlu secara manual menginstruksikannya lewat sebuah file robots.txt.

Silahkan buat file diatas, isikan dua baris ini:

User-agent: *

Disallow: /

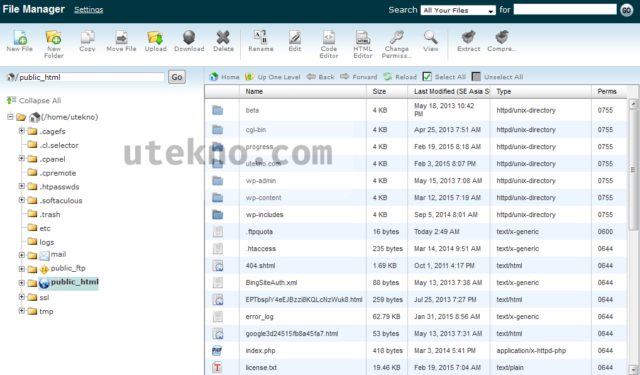

Kemudian upload di hosting web anda, bisa lewat File Manager cPanel atau FTP. Niscaya setelah beberapa hari seluruh informasi dari situs anda akan hilang dengan sendirinya dari mesin – mesin pencari, salah satunya tentu Google.

Itu yang pertama sih, kasus kedua yang dialami oleh teman lain adalah mendapatkan surat cinta dari Google karena terlalu banyak url yang memberikan link sehingga dianggap spam, ini mengakibatkan isi kontennya mirip atau sama. Isi pesannya:

Googlebot encountered extremely large numbers of links on your site. This may indicate a problem with your site?s URL structure? As a result Googlebot may consume much more bandwidth than necessary, or may be unable to completely index all of the content on your site.

Saya cek struktur urlnya di Google Webmasters ternyata halaman hasil pencarian internal di situs WordPress teman tersebut adalah tujuan – tujuan dari link tersebut. Wah… pantas saja. Ngerinya bisa mencapai ribuan lagi. Memang belum dipinalti oleh Google tapi tetap saja ada resiko. Solusinya selain kita harus melakukan disavow juga mencegah agar halaman tersebut bisa ditemukan di Google, dan ini bisa menggunakan robots.txt juga. Kalau anda menggunakan WordPress maka bisa menggunakan dua baris berikut:

User-agent: *

Disallow: /?s=*

Url diatas adalah struktur default halaman hasil pencarian internal WordPress, bisa anda sesuaikan kalau sudah diganti. Kalau ini lebih difokuskan agar para bot tidak mengindeks halaman – halaman diatas dan membuat link menuju kesana. Kalau anda menggunakan Blogger (blogspot) maka tidak perlu khawatir, sudah secara default tidak diindeks Google.

Semoga membantu.

wah ngeri juga gan kalo seperti itu.. sekarang lagi musim spammer kayaknya

di fb juga lagi marak jingling blog orang,,bisa dibuatkan gak gan script anti jingling 😀

Oh, saya malah baru tahu apa itu Jingling. Semacam pembuat trafik otomatis terarah ya. Kalau menggunakan robots.txt percuma karena fungsinya bukan untuk itu dan aturan yang adalah anjuran bukan pasti ditaati oleh bot – botnya.

Saya menganjurkan menggunakan CloudFlare atau Incapsula untuk melakukan filtering trafik bot atau yang tidak diinginkan. Sekalian blokir negara kalau parah kondisinya.